站点介绍

如果你喜欢折腾AI,那Ollama应该不会陌生,无论是油管还是B站上面,很多相关教程,如果你不喜欢看文字,可以尝试去B站或者油管搜索相关视频进行查看,如果你觉得文字更加青睐,可以看看文本推荐的站点。

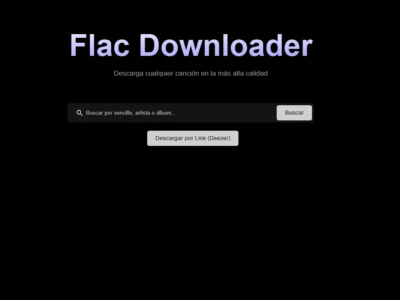

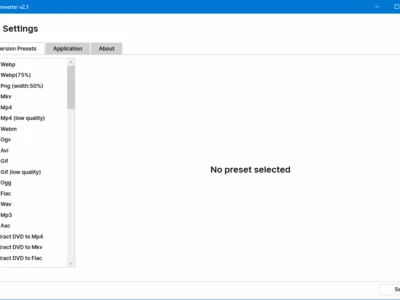

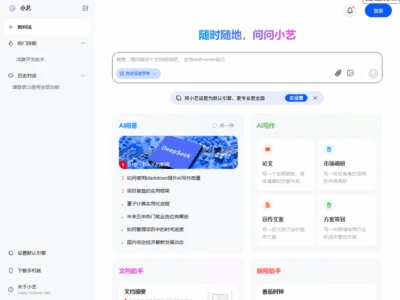

首先看看站点介绍:

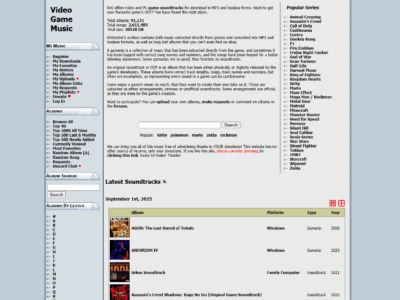

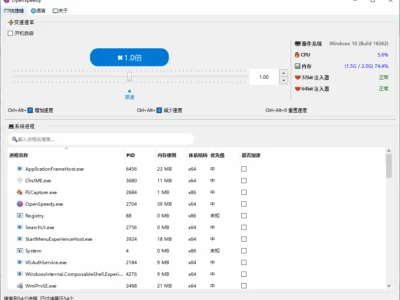

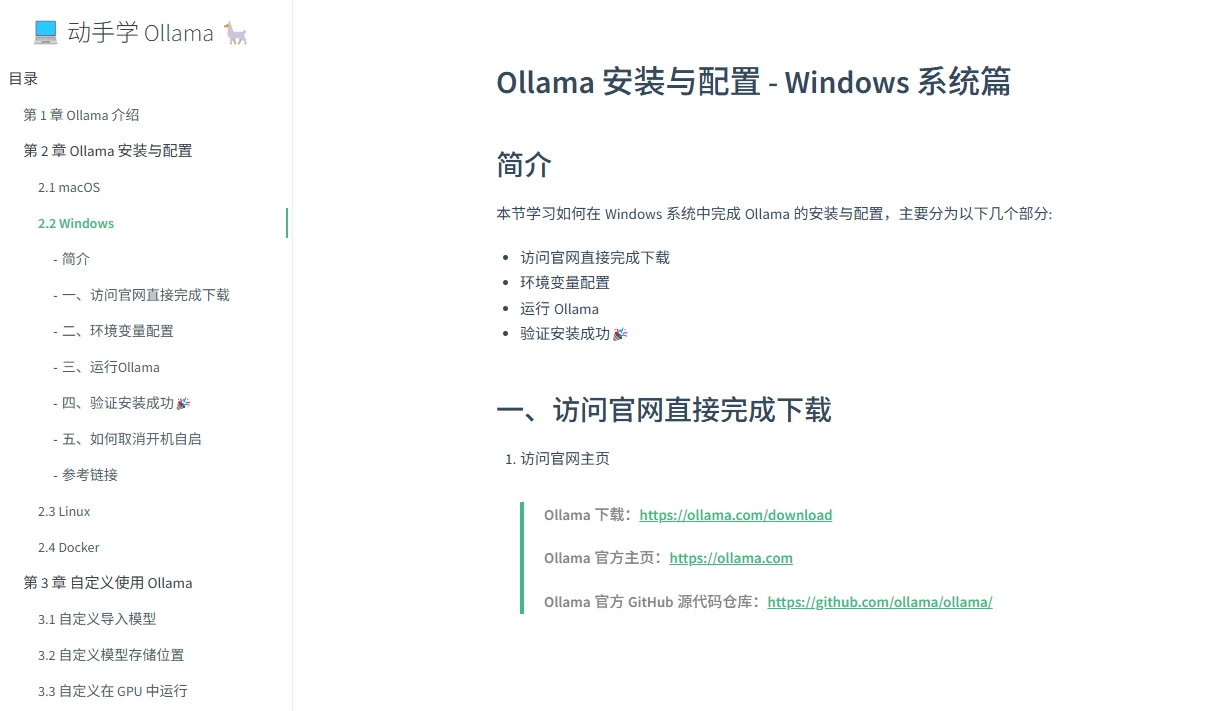

站点整体氛围左右两个区域,左边是菜单,上图已经显示了所有菜单项目,大家可以粗略的看一下,右边则是对应的详细内容。

如果你是新手,可以从头开始看,整体内容篇幅比较长,有耐心的可以慢慢看,没耐心的就根据自己的需求来选择性看吧。

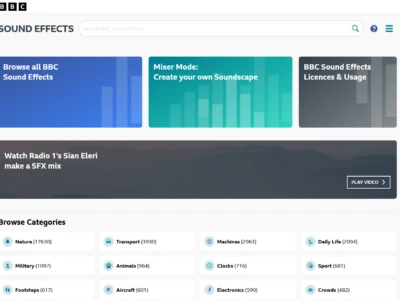

首先你得需要了解如何安装:

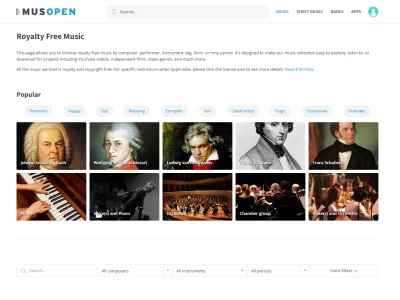

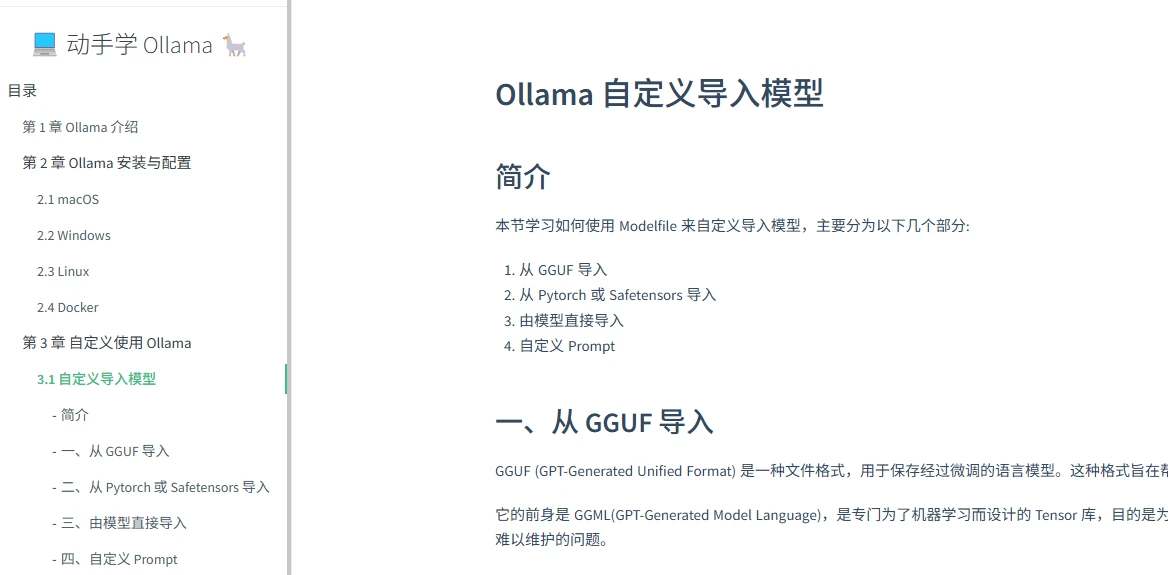

接下来就是需要了解如何导入模型:

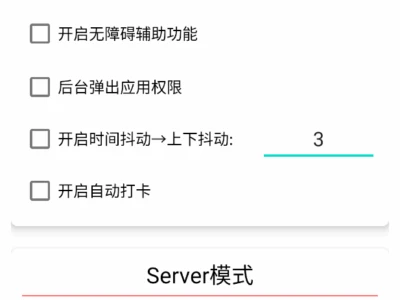

导入之后,你可能需要了解如何部署可视化界面:

一般来说,这三个步骤是必不可少的,可能根据环境不同或者需求不同,步骤有所增加,但是常规情况下这三个步骤都是需要的。

额外补充

本地部署大模型对于电脑的硬件可能有一定的要求,如果你的模型体积很大,但是配置很低,最后的结果可能就是风扇狂转、系统运行缓慢或者长时间给不出结果等等问题。

每个体量的模型针对硬件的要求是不一样的,硬件决定了你的模型运行效率,如果你想要用某个参数很大的模型,请务必考虑你的硬件是都支持。

其次,本地模型是不支持联网搜索的,虽然通过某些扩展可以实现联网搜索,但是根据网上的用户反馈,失败几率也很高。

我个人感觉,如果你想要尝鲜或者好玩,本地部署一下没啥问题,如果想要作为日常生活的一部分,请考虑电脑配置以及日常用电消耗,很多人都会用一台高配机跑本地,想想都刺激。加上现在很多模型本身就是免费的,直接使用也可以联网搜索,来的更加直接且有效。